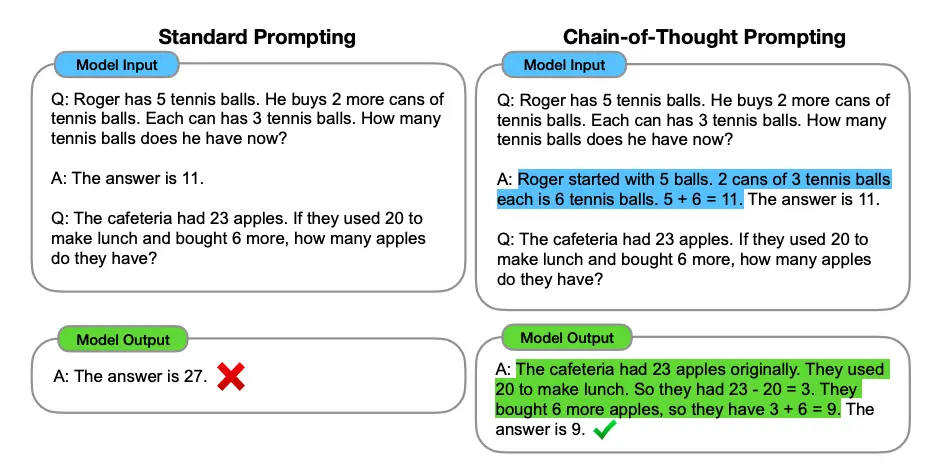

Chain of Thought Prompting (CoT) คือเทคนิคการออกแบบคำสั่งที่เน้นให้ AI แสดงกระบวนการคิดแบบขั้นตอนในการแก้ปัญหา แทนที่จะเป็นการถามคำถามง่ายๆ เทคนิคนี้ทำให้โมเดลภาษาขนาดใหญ่ (Large Language Model หรือ LLM) แสดงลำดับความคิดหรือขั้นตอนเหตุผลที่ใช้ในการหาคำตอบสุดท้าย

Chain of Thought Prompting: เทคนิคการทำให้ AI แสดงวิธีคิด

ประเภทของ Chain of Thought Prompting

- Multimodal CoT

- ทำงานกับทั้งรูปภาพและข้อความในกรอบการทำงานสองขั้นตอน

- ผู้ใช้ป้อนรูปภาพพร้อมคำอธิบายบริบทและคำถาม

- ขั้นตอนแรก: โมเดลแสดงเหตุผลว่ารูปภาพและข้อความเกี่ยวข้องกันอย่างไร

- ขั้นตอนที่สอง: โมเดลใช้เหตุผลนั้นในการอนุมานคำตอบ

- Least-to-Most Prompting

- ใช้แก้ปัญหาที่ซับซ้อน

- โมเดลแยกปัญหาใหญ่เป็นปัญหาย่อยๆ

- ผู้ใช้ป้อนปัญหาย่อยตามลำดับจนได้คำตอบสุดท้าย

- Zero-shot CoT

- ไม่จำเป็นต้องใส่ตัวอย่างการคิดเชิงตรรกะ

- ใช้วลี “let’s think this through step by step” ท้ายคำสั่ง

- กระตุ้นให้ LLM แสดงการคิดแบบเป็นขั้นตอน

วิธีการใช้งาน

การใช้ CoT ไม่ใช่แค่บอกให้ LLM แสดงวิธีทำ แต่ผู้ใช้ต้องป้อนตัวอย่างการแก้ปัญหาที่มีเหตุผลพร้อมกับคำถาม เช่น ในการแก้โจทย์คณิตศาสตร์หลายขั้นตอน:

1.แสดงกระบวนการคิด:

2 + 3 = 5

เพิ่ม 3 ได้ 8

ลบ 2 เหลือ 6

2. จากนั้นถามโจทย์ใหม่: “แก้โจทย์ต่อไปนี้ด้วยวิธีเดียวกัน: 3 + 7 – 2 + 5”

LLM จะแสดงทั้งคำตอบสุดท้าย (13) และขั้นตอนการคำนวณ

การประยุกต์ใช้

CoT มีประโยชน์ในหลายด้าน:

- การคำนวณทางคณิตศาสตร์

- การใช้เหตุผลเชิงสามัญสำนึก

- การคิดเชิงสัญลักษณ์

- การตอบคำถาม

โดยรวมแล้ว CoT เป็นวิธีการที่ช่วยให้ได้คำตอบที่แม่นยำมากขึ้นสำหรับคำถามที่ซับซ้อน